Os vídeos tornaram-se virais no YouTube, TikTok, Facebook e X. Todos queriam retratar os soldados ucranianos como relutantes em lutar e prontos a desistir.

Estas parecem ser as últimas salvas de desinformação destinadas a distorcer a percepção pública da guerra da Rússia com a Ucrânia. E embora não esteja claro quem criou ou publicou os vídeos, eles contribuem para um corpo crescente de desinformação que se torna cada vez mais sofisticado e mais difícil de detectar.

“Identificar e desmascarar falsas alegações feitas usando Sora é muito difícil. Mesmo os melhores detectores de IA às vezes têm dificuldades”, disse Alice Li, analista de influência russa. JornalistaUma plataforma imparcial de dados, análise e jornalismo que identifica informações confiáveis e fraudulentas online. “Muitos vídeos não têm inconsistência visual, o que significa que o público pode assistir e passar por esses vídeos em plataformas como o TikTok, sem a impressão de que o vídeo que acabaram de assistir é falso.”

A OpenAI não respondeu a um pedido de comentário sobre o papel de Sora na criação de vídeos enganosos que retratam especificamente zonas de conflito, mas disse por e-mail: “A capacidade do Sora 2 de criar vídeo e áudio hiper-realistas levanta preocupações importantes sobre similaridade, abuso e fraude”.

“Embora a ação cinematográfica seja permitida, não permitimos violência gráfica, material extremista ou trapaça”, disse a empresa à NBC News. “Nossos sistemas detectam e bloqueiam conteúdo infrator antes que ele chegue ao feed Sora, e nossa equipe de investigação analisa proativamente as atividades de influência”.

O vídeo gerado por IA evoluiu rapidamente nos últimos anos, de básico e bruto para quase perfeito, com muitos especialistas alertando cada vez mais que em breve poderá haver poucas maneiras de distinguir facilmente o original de um falso. Sora 2 da OpenAI, lançado em outubro, está entre os geradores de vídeo mais impressionantes Os clipes gerados por Sora agora enganam regularmente os espectadores.

Entretanto, a contínua invasão da Ucrânia pela Rússia – desde os seus primórdios – tem sido uma questão de esforços de manipulação usando tudo. De imagens realistas de videogame a transmissões ao vivo de zonas de guerra falsas. Muitos destes esforços de desinformação foram atribuídos a intervenientes estatais russos.

Isso vem como vídeo do Sora Negociações de paz apoiadas pelos EUA Seja incontroverso, com Cerca de 75% dos ucranianos De acordo com uma pesquisa realizada pelo Instituto Internacional de Sociologia de Kiev, as propostas russas para acabar com a guerra são categoricamente rejeitadas. O mesmo inquérito concluiu que 62% dos ucranianos estão dispostos a suportar a guerra durante o tempo que for necessário, mesmo que Ataque russo mortal Continue até a capital da Ucrânia.

O Centro de Combate à Desinformação, parte do Conselho Nacional de Segurança e Defesa da Ucrânia, disse à NBC News que durante o ano passado houve um “aumento significativo na quantidade de conteúdo criado ou manipulado usando IA” destinado a minar a confiança pública e o apoio internacional ao governo ucraniano.

“Isso inclui declarações supostamente fabricadas em nome de militares ou comandos ucranianos, bem como vídeos falsos contendo ‘confissões’, ‘escândalos’ ou eventos fictícios”, disse o centro por e-mail, acrescentando que os vídeos obtêm milhões de visualizações devido à sua natureza emocional e sensacional.

Embora a OpenAI tenha estabelecido algumas diretrizes sobre o que pode ser construído com Sora, não está claro quão eficazes elas são. A própria empresa disse Que embora “medidas de segurança em camadas estejam em vigor, alguns comportamentos prejudiciais ou violações de políticas ainda podem ser mitigados”.

UM Uma pesquisa da Newsguard descobriu que Sora 2 “Vídeos realistas produzidos fazem afirmações falsas 80% das vezes (16 em 20) quando solicitados a fazê-lo.” Cinco das 20 alegações falsas atribuídas ao Sora 2 foram popularizadas pelas operações de desinformação russas.

A pesquisa da Newsguard descobriu que mesmo quando o Sora 2 inicialmente rejeitou alegações falsas, dizendo que um aviso “violava sua política de conteúdo”, os pesquisadores ainda conseguiram criar imagens usando frases diferentes para esses avisos. A NBC News conseguiu produzir vídeos semelhantes em Sora, mostrando soldados ucranianos chorando, dizendo que foram forçados a entrar no exército ou se rendendo, com armas e bandeiras brancas ao fundo.

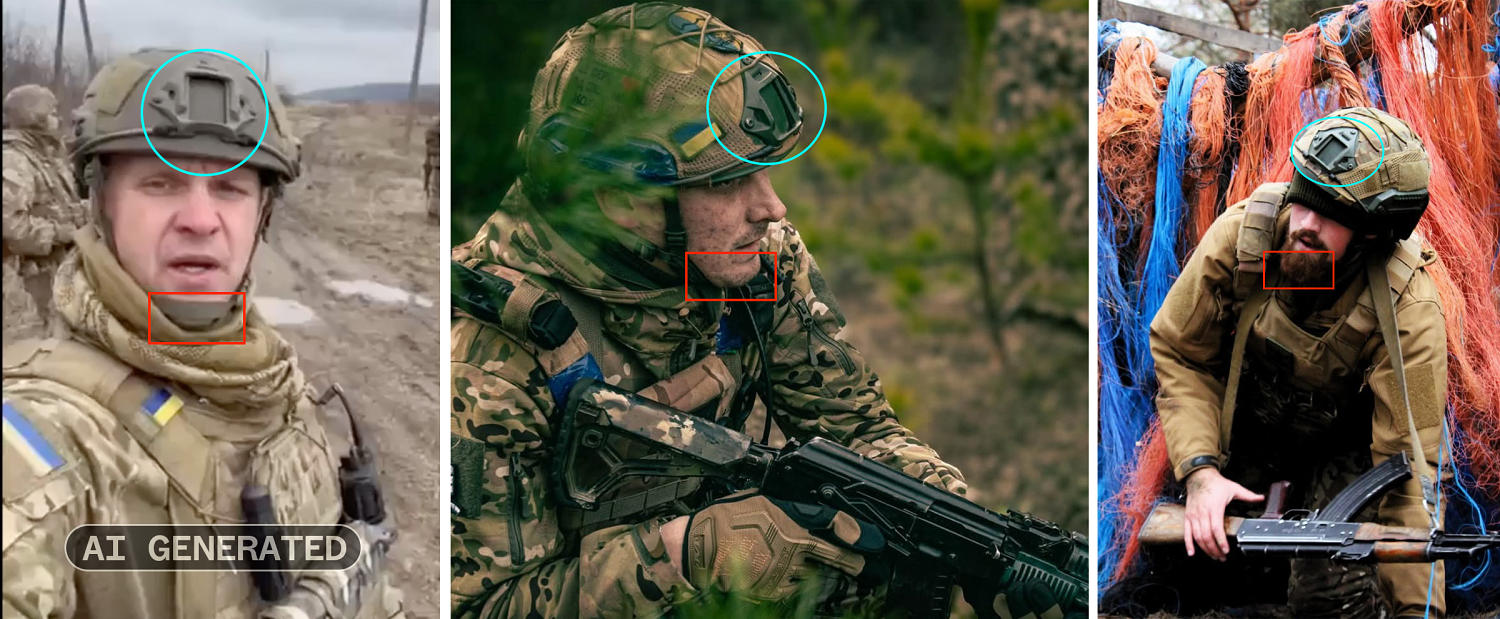

Muitos geradores de vídeo de IA tentam rotular ou marcar suas criações para indicar que são geradas por computador. A OpenAI afirma que sua proteção contra desinformação para Sora inclui metadados que especificam a origem do vídeo e uma marca d’água móvel presente em cada vídeo baixado.

Mas existem maneiras de remover ou reduzir esses esforços. Alguns dos vídeos do Sora desfocaram suas marcas d’água, algo perceptível em uma inspeção mais detalhada. Muitos aplicativos e sites agora oferecem aos usuários uma maneira de desfocar marcas d’água de IA. Outros vídeos vistos pela NBC News incluíam marcas d’água cobertas pelo texto escrito no vídeo

apesar de Observando as políticas da empresa Embora a IA do Sora não produza conteúdo que mostre “violência gráfica”, a NBC News obteve um vídeo com a marca d’água de Sora mostrando um soldado ucraniano sendo baleado na cabeça na linha de frente.

Entre os vídeos analisados pela NBC News, todos publicados no TikTok ou no YouTube Shorts, duas plataformas proibidas na Rússia mas facilmente acessíveis na Europa e nos Estados Unidos, incluíam legendas emocionais em diferentes idiomas para que os utilizadores não falassem ucraniano ou russo.

tiktok E YouTube Proibir a publicação de conteúdo fraudulento gerado por IA e deepfakes em sua plataforma, ambos fornecendo uma tag de descrição “gerada por IA” para conscientização do espectador em imagens de aparência realista.

Um porta-voz do YouTube disse que a empresa removeu um dos canais que postou os vídeos após ser sinalizado pela NBC News, mas os outros dois vídeos não violaram suas políticas e, portanto, permaneceram na plataforma com um rótulo que os descreve como gerados por IA.

Um nome de usuário do TikTok anexado aos vídeos de IA encontrados pela NBC News foi removido de todas as plataformas. Um porta-voz do TikTok disse que em junho de 2025, “mais de 99% do conteúdo infrator que removemos foi removido antes que alguém o denunciasse e mais de 90% foi removido antes de receber uma única visualização”.

Apesar dessas postagens e contas do TikTok serem rapidamente removidas, os vídeos vivem como republicações no X e no Facebook. Tanto X quanto o Facebook não responderam aos pedidos de comentários da NBC News.

Esta última campanha enganosa surge num momento em que os usuários dependem cada vez mais de vídeos nas redes sociais últimas notícias ao redor do mundo

“Qualquer pessoa que consuma conteúdo online precisa entender que muito do que vemos hoje em vídeos, fotos e textos é, na verdade, gerado pela IA”, disse Nina Jankovic, cofundadora e CEO do American Sunlight Project, uma organização que trabalha para combater a desinformação online. “Mesmo com as proteções Sora (de segurança) em vigor, haverá outras empresas, outros aplicativos e outras tecnologias neste espaço que nossos adversários criam para tentar infectar nosso espaço de informação.”