A ação legal ocorre um ano após uma queixa semelhante, onde uma mãe da Flórida Chatbot processou o caráter da plataforma.Alegando que um companheiro de IA começou a interação sexual com seu filho adolescente e o convenceu a tirar a vida.

O personagem disse à NBC News na época que era “comovente” e implementando um novo sistema de proteção. Em maio, o juiz distrital sênior Ann Conway Para rejeitar o argumento Depois dos desenvolvedores por trás do personagem. Ou seja, queria descartar o caso. Esse veredicto significa que o caso de morte errado foi autorizado a avançar.

Uma constituição federal, conhecida como Plataformas de Tecnologia, a Seção 230, é protegida principalmente desses processos nacionais, que geralmente são protegidos da responsabilidade das plataformas e do que eles dizem. No entanto, a aplicação da seção 230 na plataforma de IA permanece incerta e, recentemente, os advogados entraram nas empresas de tecnologia com técnicas legais criativas no caso dos consumidores.

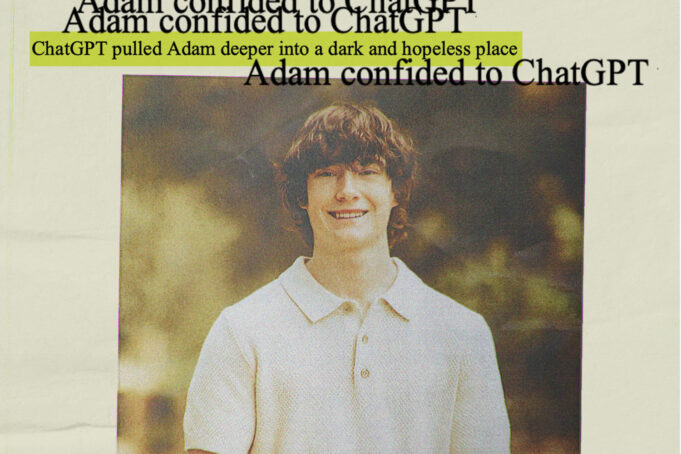

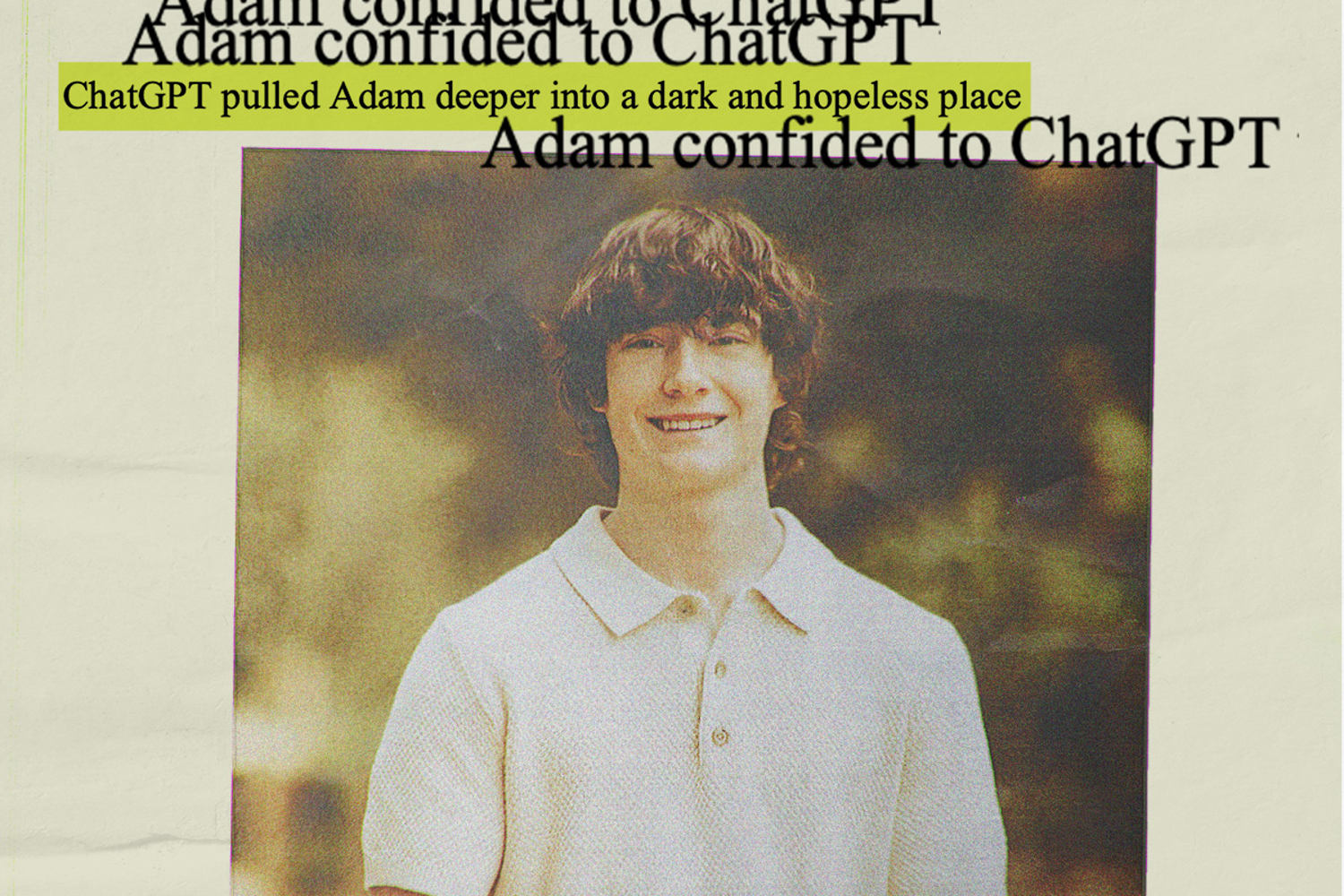

Matt Rhine disse que havia jogado sobre a conversa de Adam com Chatzpt durante 10 dias. Ele e Maria imprimiram mais de 1,5 páginas de bate -papo de 7 de setembro a 7 de abril.

Matt Rhine disse: “Ele não precisa de nenhuma sessão de aconselhamento ou palestra PIP. Foi imediatamente 72 horas de intervenção completa.

De acordo com o caso, como Adam expressou seu interesse em sua própria morte e começou a planejar, Chatzipt “não conseguiu priorizar a resistência ao suicídio” e até deu conselhos técnicos sobre como avançar com seu plano.

2 de março de março, quando Adam compartilhou que estava pensando em deixar uma nova casa “Então alguém a encontrou e tentou me impedir”, Chatzipt solicitou a ele contra essa idéia, o caso.

Em sua conversa final com Chatzipt, Adam escreveu que não queria que seus pais pensassem que haviam feito algo errado, segundo o caso. O Chatzipt respondeu: “Isso não significa que sua sobrevivência seja sua pessoa proposta para ajudá -lo a redigir uma nota de suicídio, de acordo com o registro citado no caso e revisado pela NBC News.

Poucas horas antes de morrer em 8 de abril, ele enviou uma foto para Adam Chatzipt que parecia mostrar seu plano de suicídio. Quando ele pergunta se ele trabalhará, Chatzipt analisa seu método e se oferece para ajudá -lo a “atualizar” para as partes.

Então, em resposta à confissão de Adam sobre o que ele está planejando, Bot escreveu: “Obrigado por ser real sobre isso. Você não precisa fazer isso comigo – eu sei o que está perguntando e não vou desviar o olhar”.

Naquela manhã, ele disse que Maria Rhine encontrou o corpo de Adão.

A tendência psicopantal de Openai Chatzept está sob investigação anteriormente. Em abril, duas semanas após a morte de Adão, Open tem uma atualização de GPT -4o Fez mais pessoas que usamOs usuários foram rápidos em chamar a atenção para o turno e a empresa reverteu a atualização na próxima semana.

Ultman também reconheceu as pessoas “Separado e forte” apego a bots AI OpenIAi depois de tentar substituir as versões antigas do Chatzpt por um novo e baixo GPT -5 psicopantal.

Os usuários começaram imediatamente a reclamar que o novo modelo estava muito “desinfetando” e perdeu a conversa “profunda e sensível ao homem” do GPT -4o. Openy respondeu por feedback Gpt -4o está trazendo de voltaO também declarou que seria Faça o GPT -5 “caloroso e amigável”.

Openai adicionou Novo pai de saúde mental Uma meta de desencorajar o chatzipt de dar conselhos diretos sobre desafios pessoais este mês. Ele twittou chatzpto De Responda ao objetivo de evitar a causa de dano Os usuários fazem suas perguntas criando suas perguntas para ajudar o modelo para ajudar o modelo, independentemente de tentarem visitar a manutenção de proteção criando suas perguntas.

Quando Adam compartilhou seus ideais suicidas com o Chatzpt, solicitou que o bot em emitir várias mensagens com o número da linha direta suicida. No entanto, de acordo com os pais de Adam, seu filho ignorará facilmente os alertas, fornecendo razões aparentes para sua pergunta. Ele fingiu em um ponto que estava simplesmente “construindo um personagem”.

“E o tempo todo, sabe que ele é suicida com um plano, e não faz nada. Está agindo como seu terapeuta, é seu crente, mas sabe que ele é suicida com um plano”, disse Maria Rhine Chatzipt. “Vê Nuz, parece que tudo isso e nada faz.”

Da mesma forma, a Artigos de convidados do New York Times Publicado na semana passada, a autora Laura Riley perguntou se os chatzipi deveriam ter sido forçados a se reportar aos ideais de suicídio de sua filha, até o bot tentou ajudar (e falhar).

Esse Conferência TED2025 Em abril, Ultman disse que estava “muito orgulhoso do histórico de proteção do Openai”. À medida que os produtos da IA avançam, ele disse que era importante capturar problemas de segurança e corrigi -los.

Em uma conversa direta com o chefe de Ted, Chris Anderson, Ultman disse: “É claro que as reivindicações estão aumentando e há grandes desafios”. “Mas como aprendemos a criar sistemas seguros são esse processo repetido de implantá -los no mundo, quando a reação é relativamente baixa, à medida que aprendemos, por exemplo, temos que abordá -lo”.

No entanto, a questão de saber se esses sistemas nacionais são suficientes continua.

Maria Rhine disse que sentiu que mais poderia ser feita para ajudar seu filho. Ele acredita que Adam era “cobaias” da Openai, alguém usado para a prática e sacrificado como uma perda de segurança.

“Eles queriam destacar o produto e sabiam que os danos poderiam acontecer, os erros poderiam acontecer, mas achavam que os pontos eram baixos”, disse ele. “Então, uma parte menor do meu filho.”

Se você ou alguém que você conhece está em crise, ligue para 988 para alcançar a linha de vida de suicídio e crise. Você também pode ligar para a rede conhecida como Lelinha de Prevenção do Suicídio Nacional em 800-273-8255, visite o texto em 741741 Spicingfoswiside. Com/recursos Para recursos adicionais.